Das musst du wissen

- Die EU fördert das Projekt iBorderCtrl, bei dem verschiedene Technologien für besseren Grenzschutz getestet werden.

- Darunter auch ein Lügendetektor, der lernen soll, Menschen mit unlauteren Absichten an der Grenze zu erkennen.

- Doch diesem System fehlt jede wissenschaftliche Basis und es wurde mit viel zu wenig Daten entwickelt.

«Schau mich an!», fordern wir, wenn wir das Gefühl haben, dass uns jemand etwas verheimlicht. Irgendwo dort, im Gesicht des Gegenübers müsse doch die Wahrheit zu finden sein, glauben wir. Etwa in einem verräterischen Augenzucken, dem schuldbewussten Abwenden des Blickes oder den sprichwörtlichen Schweissperlen auf der Stirn.

Das ist ein grosser Irrtum. «Solche Signale sagen nichts darüber aus, ob jemand lügt oder etwas zu verbergen hat», sagt Tuule Grolig, Expertin für die Erkennung von Täuschungsverhalten am Psychologischen Institut der Universität Zürich. «Viele Menschen, häufig auch Polizisten und andere, die beruflich mit Lügnern zu tun haben, glauben zu Unrecht, diese an solchen nicht-verbalen Signalen erkennen zu können.» Denn weder der Blick noch andere Gesichtsausdrücke oder äusserliche Merkmale würden helfen, glasklar zwischen den Menschen zu unterscheiden, die die Wahrheit sagen und jenen, die uns täuschen wollen.

Dieser wissenschaftlichen Tatsachen ungeachtet verfolgt ein europäisches Forschungsprojekt dennoch genau dieses Ziel. Und es geht sogar noch einen Schritt weiter: Kein Mensch, sondern eine künstliche Intelligenz (KI), soll die Wahrheit von unseren Gesichtern ablesen.

4,5 Millionen Euro für iBorderCtrl

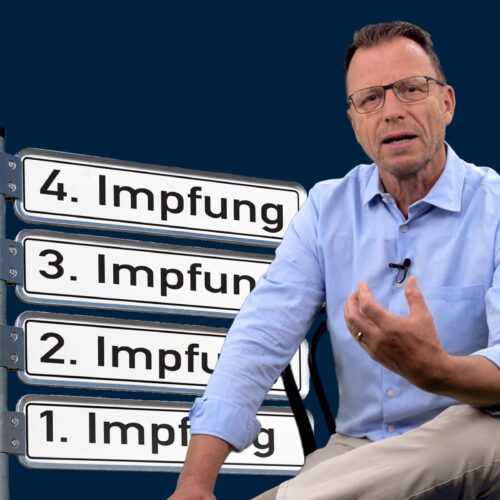

Dieses «Automatic Deception Detection System» – nennen wir es einen KI-Lügendetektor – ist Teil eines Projektes mit dem Namen iBorderCtrl, welches die EU mit 4,5 Millionen Euro vollständig und für drei Jahre finanziert. Im Rahmen dieses Projektes werden verschiedene Technologien zur verschärften Kontrolle von Menschen, die aus sogenannten Drittstaaten über die Landesgrenzen in die EU einreisen wollen, erprobt. Dazu gehören unter anderem Computerprogramme zur biometrischen Gesichtsmodellierung, zur Erfassung von Fingerabdrücken und Handflächenvenen und zur Verifizierung von Dokumenten – und eben zur automatischen Erkennung von Menschen mit unlauteren Absichten durch den KI-Lügendetektor. Vereinfacht gesagt geben all diese Systeme verschiedene Risikowerte aus, die dann abschliessend zu einem einzigen Wert zusammengerechnet werden, welchen der Grenzbeamte sieht. Hat ein Passagier einen niedrigen Risikowert, wird er durchgewunken. Bei einem hohen Wert schlägt das System Alarm: Diese Person sollten Grenzschützer besser noch einmal genauer kontrollieren, durchsuchen oder vernehmen.

Und so muss man sich den Grenzübertritt mit iBorderCtrl vorstellen: Schon vor Beginn der Reise sollen sich Einreisewillige am heimischen Computer oder am Smartphone registrieren. Dabei stellt ihnen ein Avatar, also die Computeranimation eines Grenzbeamten, Fragen. Zum Beispiel «was befindet sich in Ihrem Koffer?» oder «was ist Ihre Staatsangehörigkeit?». Währenddessen filmt eine Kamera die Antwortenden. Das Video wird dann von der künstlichen Intelligenz auf die eingangs erwähnten nicht-verbalen Signale hin untersucht. So soll erkannt werden, ob ein Mensch, die Intention hat zu täuschen, oder auf deutsch: ob er etwas im Schilde führt.

Nur 32 Probanden

Bizarrerweise haben die Entwickler des KI-Lügendetektors die neuronalen Netze, die das Herzstück der künstlichen Intelligenz bilden, mit gerade mal 32 Probanden trainiert. Die Hälfte dieser Probanden baten sie, vorsätzlich zu lügen, die anderen durften die Wahrheit sagen. Um zu testen, wie treffsicher ihr System ist, nutzten die Entwickler danach denselben Datensatz von Filmen. Ein Vorgehen, das «cross-validation» genannt wird, und das unter Computerwissenschaftlern bei so kleinen Datenmengen durchaus üblich ist. Resultat: Der KI-Lügendetektor erkannte circa 75 Prozent der Lügner als solche. Die Trefferquote hoffe man mit mehr Testpersonen noch erhöhen zu können, schreiben die Entwickler in einem Bericht. Auf über 80 Prozent könne man es schaffen.

Aber abgesehen von den vielleicht 15 bis 20 Prozent der Lügner, die dann immer noch unentdeckt blieben und einer ungefähr gleichen Anzahl fälschlich Verdächtigter, gibt es noch ein anderes Problem mit dem System, erklärt Matteo Sorci, Experte für Maschinelles Lernen an der Eidgenössischen Technischen Hochschule Lausanne und Mitbegründer der Firma Nviso, die mit Hilfe künstlicher Intelligenz Gesichter auf Emotionen hin untersucht. «Selbst wenn so ein System eine Trefferquote von 90 Prozent hat, bedeutet das nicht, dass es sich verallgemeinern lässt», sagt der KI-Experte. «Ausserhalb des Labors macht es vielleicht viel mehr Fehler.»

Lügen zu komplex für KI

Damit ein solches Programm wirklich zuverlässig funktioniert, müssten viel mehr Faktoren in das Modell, welches dem Algorithmus zugrunde liegt, einfliessen. «Ein Algorithmus braucht Wissen, so wie eine Maschine Öl braucht», sagt Sorci. So müssten beim Design hunderte von Faktoren einfliessen, unter anderem, wie sich die Persönlichkeit, die kulturelle Herkunft, die psychische und gesundheitliche Verfassung einer Person auf die vermeintlichen nicht-verbalen Signale auswirken können.

Um also tatsächlich zu funktionieren, müsste der KI-Lügendetektor mit zehntausenden Filmen trainiert und validiert werden, und das Modell, welches dem Algorithmus zugrunde liegt, müsste viel mehr Variablen enthalten. Zudem: Das Täuschen sei bei Menschen ein facettenreicher Vorgang. Wohl zu komplex, als dass es mit dem jetzigen Design detektiert werden könne, sagt Sorci. «So wie der Lügendetektor aufgebaut ist, erkennt er wohl eher das Unbehagen einer Person, und nicht ob sie lügt.»

Soll Terroristen abschrecken

Offiziell soll das Projekt helfen, illegale Einwanderer abzuschrecken und dadurch Terrorismus und Kriminalität zu bekämpfen. Dabei ist es aber nicht auszuschliessen, dass der KI-Lügendetektor auch auf legale Migranten, auf Menschen, die vor Krieg und Verfolgung fliehen, eine abschreckende Wirkung haben könnte. Und dass eine automatische Überwachung von Reisenden auf Grundlage von unwissenschaftlichen Kontrollinstrumenten auch nach hinten los gehen kann, zeigt ein Versuch aus den USA. Dort hatte die Verkehrssicherheitsbehörde TSA über Jahre hinweg Videoaufnahmen an Flughäfen maschinell auf ähnliche nicht-verbale Signale von Passagieren hin untersucht wie der europäische KI-Lügendetektor. Der Plan: Kriminelle und Terroristen entlarven. Als das 2015 öffentlich wurde, hagelte es heftige Kritik: Unter anderem führe das Computerprogramm dazu, dass Menschen wegen ihrer Hautfarbe verdächtigt würden. Auf öffentlichen Druck stellte die Regierung das eine Milliarde Dollar teure Projekt ein.

Die Europäische Kommission hingegen zeigt sich begeistert über die Fortschritte von iBorderCtrl und lobte es in einer Pressemitteilung kürzlich sogar als Erfolgsprojekt. Seit vergangenem Herbst wird iBorderCtrl an verschiedenen Grenzübergängen in Ungarn, Griechenland und Lettland getestet.

So kommt man einem Lügner auf die Schliche

Einer möglichen Einführung des KI-Lügendetektors nach Beendigung des Projektes steht Psychologin Grolig aber skeptisch gegenüber. Zwar glaubt sie, dass künstliche Intelligenz helfen kann, Menschen, die täuschen wollen, zu überführen. «Aber dazu müssen wir nicht darauf achten, wie etwas gesagt wird, sondern vielmehr darauf, was gesagt wird.»

Denn einen Lügner könne man am ehesten entlarven, in dem man der Person unerwartete Fragen stelle und die Antworten dann auf überprüfbare inhaltliche Details hin untersuche. So könne man auch verhindern, dass sich Kriminelle auf die vorhersehbaren Fragen eines Avatars vorbereiten und ihr Verhalten entsprechend trainieren. Und überhaupt: Dass sich Terroristen oder Menschen mit kriminellen Absichten von einem Avatar wirklich aus der Ruhe bringen lassen, ist sowieso zweifelhaft. Die Lüge ist quasi ein Kulturgut, das die Gesellschaft über Jahrtausende zur Perfektion gebracht hat. Menschen schaffen es immer wieder, einem anderen ohne mit der Wimper zu zucken ins Gesicht zu lügen. Warum sollten solche Leute mehr Skrupel vor einer Maschine haben?